Estudo de caso sobre a utilização do Benchmarking Indireto em combinação com o Design Thinking para a implementação de uma funcionalidade.

Escrito por: Gabriel Belisiario

April 20, 2022

Disclaimer: As informações da empresa e os dados originais do projeto foram devidamente alterados ou removidos por questões de privacidade.

O aplicativo de uma empresa que atua no setor de educação foi lançado para Android e, após a aplicação de uma nova identidade visual na interface do usuário, uma das prioridades imediatas se trata de aprimorar a usabilidade das principais tarefas do usuário.

Este estudo de caso demonstrou por meio da técnica de Benchmarking indireto em combinação com a metodologia Design Thinking, a exploração, compreensão, e adaptação da funcionalidade de “continuar assistindo” presente em aplicativos de streaming.

Por fim, foi realizada a análise de dados e a remoção de outliers, resultando em um aumento de eficiência de 77% em relação ao aplicativo de uma empresa concorrente, 80% em relação ao aplicativo de uma segunda empresa concorrente, e 69% em relação ao próprio aplicativo antes da implementação da funcionalidade.

Um grupo educacional lançou um aplicativo para Android, cuja interface foi implementada utilizando um kit padrão da Google, Material Design.

Após o redesign e correções técnicas implementadas no aplicativo, a empresa possui como uma de suas prioridades o aumento da eficiência das principais user tasks (tarefas do usuário).

Assim, inúmeras metodologias e técnicas podem ser empregadas neste contexto de aprimoramento. Entre elas, o Design Thinking e o Benchmarking.

Portanto, este estudo de caso possui o intuito de demonstrar como as técnicas de Design Thinking e Benchmarking Indireto foram utilizados na implementação de uma funcionalidade no aplicativo do grupo educacional.

Esta sessão do artigo objetiva explicar brevemente sobre as técnicas Design Thinking, Benchmarking, e suas variações, benchmarking direto e indireto.

O Design Thinking se trata de uma abordagem de resolução de problemas, caracterizado por buscar soluções por meio da exploração estruturada de dois espaços distintos, o espaço do problema e o espaço da solução, respectivamente (Henriques et al., 2022).

A expressão “Design Thinking” foi primeiramente utilizada por acadêmicos no início da década de 90 e popularizada pela IDEO, empresa de design e inovação fundada em 1991 (Pinheiro e Alt, 2011).

O benchmarking envolve a medição contínua de produtos, serviços e práticas em relação aos concorrentes ou empresas líderes do setor (Kearns apud Stapenhurst, 2009).

Benchmarks podem ser usados para ancorar comparações e fornecer um ponto de referência para avaliar dados (Lidwell et al., 2010).

4 tipos de Benchmarking podem ser citados:

(Cook, 2017)

Uma análise competitiva é geralmente utilizada para compreender o que as empresas competidoras são fazendo e se suas práticas devem ser seguidas.

Muitas vezes, no entanto, as análises são feitas apenas por competidores diretos, nos quais podem não oferecer a melhor experiência (Kantamneni, 2022).

Por isso, a prática de Benchmarking envolvendo empresas e produtos não concorrentes deve ser seguida e se trata do foco principal do presente artigo.

A Imagem 1 consiste na tela inicial atual do aplicativo.

Conforme o conceito de Benchmarking Direto, a comparação com dois aplicativos de empresas concorrentes foi realizada utilizando a mesma user task (ou tarefa do usuário) como base. A tarefa consiste em “Continuar a assistir a última aula”.

Assim, a Imagem 2 exibe a comparação do tempo de conclusão da tarefa, medida por meio de um teste de usabilidade remoto não-moderado.

Logo, é possível perceber que se tratando do Benchmarking entre concorrentes direto, o aplicativo já possui o melhor desempenho na execução da tarefa, com 32% de eficiência em relação à concorrente 1, e 55% em relação à concorrente 2.

Apesar do resultado satisfatório envolvendo o Benchmarking Direto no tempo de execução da Tarefa 1, o Benchmarking Indireto foi utilizado na fase de imersão do design thinking por possibilitar a compreensão de diferentes práticas adotadas por aplicativos de empresas não concorrentes.

Assim, um benchmarking foi realizado em 3 plataformas de streaming. Como critérios de escolha das plataformas utilizadas para teste, foram definidos dois critérios:

A conclusão principal do Benchmarking Indireto diz respeito à praticidade proporcionada pelos aplicativos de streaming para continuar a assistir filmes e séries já iniciados. Assim, a tarefa conta com uma baixa carga cognitiva e propicia um aumento de eficiência em sua conclusão.

No entanto, ao mesmo tempo em que os aplicativos proporcionam uma facilidade para continuar a assistir filmes e séries, o mesmo não ocorre para a remoção deles da lista, prejudicando a usabilidade ao não proporcionar a opção ao usuário.

Levando em consideração a principal conclusão do benchmarking indireto, que consiste na agilidade em continuar assistindo um conteúdo iniciado, a etapa de análise e síntese possui o objetivo de adaptar essa funcionalidade considerando o contexto do aplicativo educacional.

Para isso, utilizou-se da técnica “Crazy 8's”, que consiste em elaborar oito ideias de maneira livre e em um curto período de tempo. Adicionalmente, é possível fazer futuras iterações com mais detalhes após cada sessão (Perea e Giner, 2017).

Os 8 esboços oriundos da técnica Crazy 8’s foram feitos em um papel e o mesmo já não se encontra disponível. No entanto, a imagem 3 apresenta 4 esboços escolhidos e já adaptados para um protótipo de baixa fidelidade.

Após a elaboração dos esboços iniciais, houve uma interação com os membros da equipe com o intuito de definir qual opção estaria mais condizente com o produto e com as funcionalidades que a nova feature deveria conter.

Assim, seja por aspectos técnicos, funcionais e estéticos, dos 4 esboços finais, foi escolhido o que mais se adequou a proposta desejada.

Por meio de um Wireframe, conforme Imagem 4, foi possível tangibilizar alguns aspectos essenciais da nova funcionalidade, tais como as informações que deveriam constar, como o nome da disciplina, da aula e do professor, e um menu superior que pode ser utilizado para marcar a aula como concluída, removê-la da lista, acessar material complementar, entre outras opções.

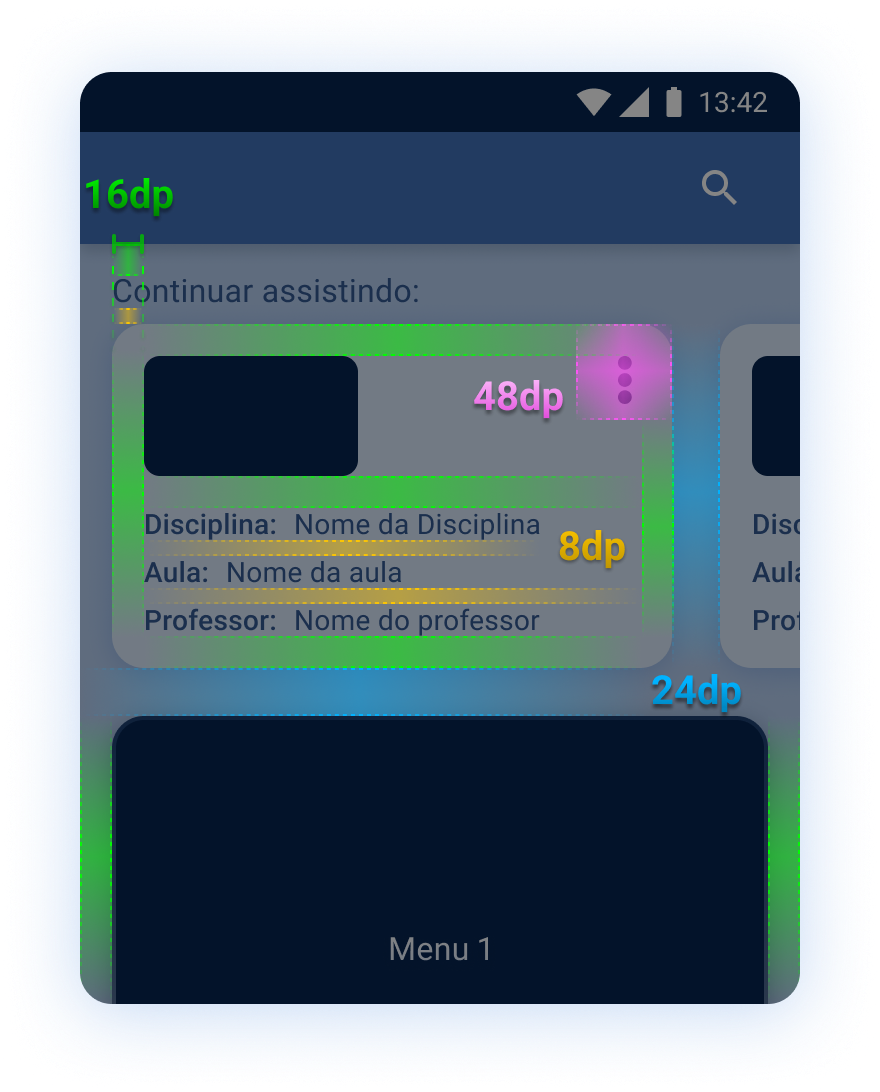

Conforme detalhado no artigo sobre o redesign da interface do usuário (UI) do aplicativo, a estrutura interna, incluindo espaçamento, margens internas e externas, e área de toque mínima recomendada, segue as diretrizes do Material Design da Google.

Assim, a Imagem 5 exibe os aspectos de espaçamento e distribuição de espaço, proporcionando uma boa usabilidade, como por exemplo a adequação ao tamanho de toque mínimo recomendado, de 48dp, e um padrão harmonioso para a UI do aplicativo de maneira geral.

Um protótipo funcional, exibindo a nova funcionalidade implementada, pode ser visto na Imagem 6. Com isso, é possível avançar para o último teste do Design Thinking, que consiste em testar o protótipo com usuários.

A escolha do melhor método de avaliação depende de muitas variáveis.

Para a avaliação da nova funcionalidade implementada, foi selecionado o teste de usabilidade remoto não moderado, uma vez que a funcionalidade não requer a presença de um moderador para direcionar o usuário e fornecer contexto para a conclusão da tarefa.

Além disso, a eficiência de tempo e custo também foi considerada.

Conforme ilustrado na Imagem 7, os dados brutos de uma amostra do teste de usabilidade remoto não moderado são apresentados.

Mesmo com alguns usuários concluindo a tarefa em um tempo discrepante dos demais (conhecidos como “outliers”), a média resultante de 4,9 segundos já representa quase metade do tempo de realização manual da tarefa, que é de 9,37 segundos, conforme Imagem 2.

Portanto, considera-se que os usuários outliers não tenham executado a tarefa utilizando a funcionalidade implementada.

Assim, para obter uma conclusão mais precisa do tempo de realização da tarefa, é necessário remover os outliers.

“Sempre que analisar dados de tempo, é fundamental observar a distribuição. Isso é particularmente verdadeiro para dados de duração de tarefas coletados por meio de ferramentas automatizadas (quando o moderador não está presente).”

(Albert e Tulis, 2022)

Conforme Albert e Tulis, 2022, a identificação de outliers pode ser feita utilizando tempo de conclusão de tarefa que são duas ou três vezes desvios padrão acima da média ou definindo um limite aceitável do tempo de conclusão da tarefa.

Assim, realizando o filtro dos discrepantes, o resultado pode ser visto na Imagem 8.

Considerando a remoção dos outliers, a Imagem 9 exibe o ganho de eficiência em relação ao Concorrente 1 de 77%, ao Concorrente 2 de 80%, e ao próprio aplicativo antes da implementação da funcionalidade, com um aumento de 69%.

Por meio da técnica de Benchmarking, em sua variação externa e não concorrente, foi possível explorar a usabilidade e funcionalidades de aplicativos de streaming.

Com isso, a adaptação da funcionalidade de continuar assistindo um conteúdo iniciado foi adaptado ao contexto do aplicativo educacional.

Os resultados demonstram um aumento de eficiência elevados em relação aos aplicativos de concorrentes diretos e ao próprio aplicativo quando a comparado ao modo padrão de concluir a tarefa em questão.

Por fim, enfatiza-se a importância da técnica de Benchmarking até mesmo em aplicativos de concorrentes não diretos, visto que boas práticas e diferentes maneiras de realizar uma tarefa podem ser compreendidas e adaptadas.

Obrigado pela leitura!

Sugestões, críticas ou elogios por favor entre em contato via e-mail ou LinkedIn.

Caso queira se aprofundar nos temas de Benchmarking e Design Thinking, leia os artigos:

Albert, B.; Tullis, T. Measuring the User Experience: Collecting, Analyzing, and Presenting UX Metrics. 3. ed. Cambridge: Elsevier Inc, 2022. 384 p. ISBN 978–0–12–8180808.

Cook, S. Measuring Customer Service Effectiveness. New York: Routledge, 2017. 174 p. ISBN 9781138256200.

Henriques, C.; Ignácio, E.; Pilar, D. UX Research com sotaque brasileiro: Ou sobre como fazer pesquisas com usuários no Brasil sem apegos acadêmicos ou erros do mercado. Casa do Código, 2022. 432 p. ISBN 978–85–5519–319–4.

Kantamneni, S. User Experience Design: A Practical Playbook to Fuel Business Growth. Hoboken: John Wiley & Sons, Inc., 2022. 320 p. ISBN 9781119829386.

Lidwell, W.; Holden, K.; Butler, J. Universal Principles of Design: 125 Ways to Enhance Usability, Influence Perception, Increase Appeal, Make Better Design Decisions, and Teach through Design. Rockport Publishers, 2010. 248 p. ISBN B005SN4Y4C.

Perea, P.; Giner, P. UX Design for Mobile. Packt Publishing, 2017. 354 p. ISBN 9781787283596.

Pinheiro, T.; Alt, L. Design Thinking Brasil. Rio de Janeiro: Elsevier Editora Ltda., 2011. 248 p. ISBN 978–85–352–4567–7.

Stapenhurst, T. The Benchmarking Book: A How-to-Guide to Best Practice for Managers and Practitioners. Routledge, 2009. 496 p. ISBN 1138464449.

As ferramentas e metodologias mais adequadas de acordo com o contexto do projeto:

Aplicativo Educacional (UI)

Estudo de caso sobre as mudanças implementadas na interface do usuário (UI) do aplicativo de uma empresa atuante na área da educação.

Aprimorando o App WhatsApp usando Reviews

Simulando um cenário real de trabalho por parte de um UX Designer e sua equipe

Estúdio de Tatuagem Dylest

Estudo de caso que aborda a contextualização, desk research, benchmarking, arquitetura de informação e o teste de usabilidade.

App de Delivery de Hortifruti

Uma rede de hortifruti gostaria de desenvolver um aplicativo. Acompanhe o processo inicial de pesquisa até a apresentação do conceito.